Ci ho messo un po’ prima di pubblicare questo articolo: volevo davvero andare a fondo. Negli ultimi mesi si parla ovunque di Intelligenza Artificiale , nuovi strumenti, nuove opportunità, nuove competenze da acquisire.

Ma dietro l’entusiasmo collettivo, ho iniziato a notare un’altra emozione, più silenziosa e sottile: la sensazione di essere sempre indietro.

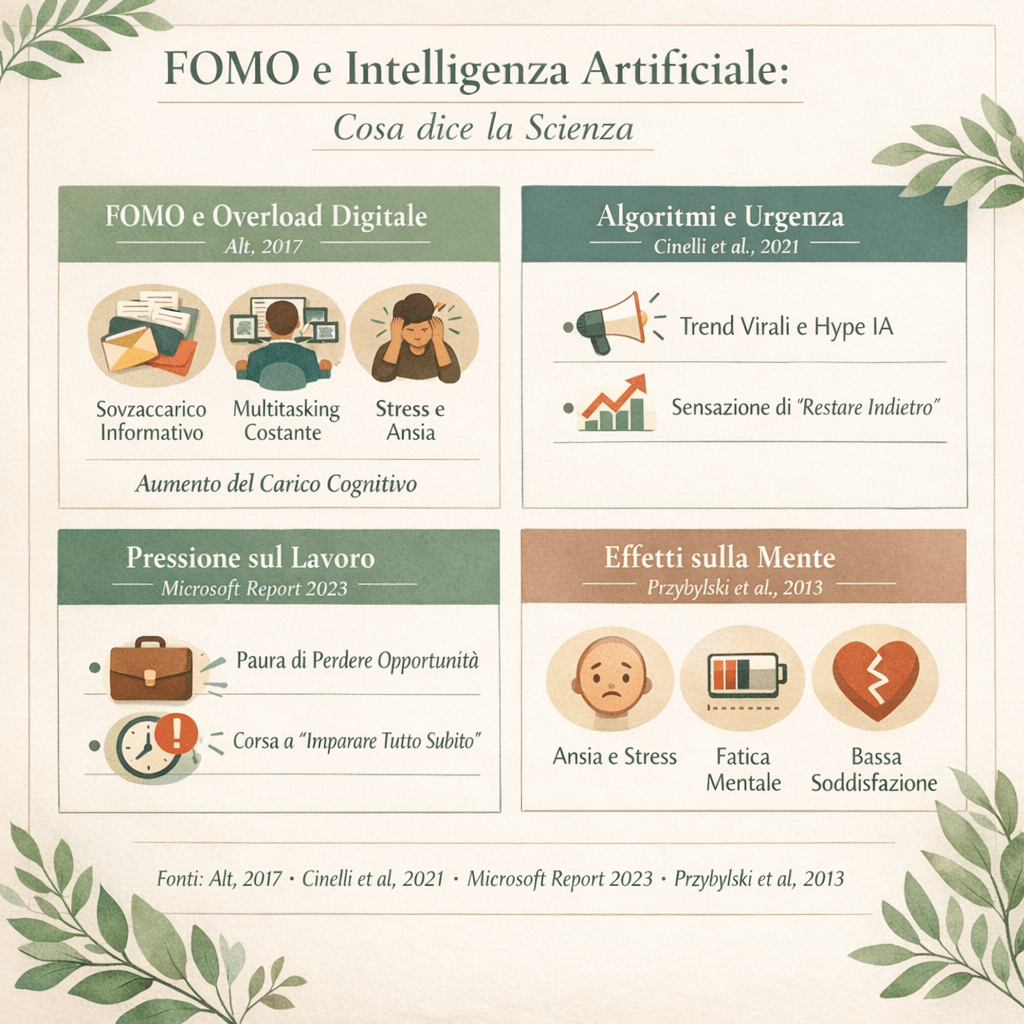

Quella sensazione ha un nome preciso: FOMO – Fear of Missing Out, la paura di perdersi qualcosa. È un fenomeno studiato già prima dell’esplosione dell’IA. Nel lavoro di Przybylski e colleghi (2013) viene descritta come la percezione ansiosa che gli altri stiano vivendo esperienze migliori o più importanti delle nostre, spingendoci a restare costantemente connessi per non “perdere” informazioni o opportunità.

Con l’arrivo dell’Intelligenza Artificiale questa dinamica non è scomparsa: si è trasformata.

Oggi non vediamo più solo foto di viaggi o vite perfette: vediamo colleghi che sperimentano nuovi tool, professionisti che automatizzano processi, creator che producono contenuti in quantità enorme grazie all’IA.

Ogni settimana sembra esserci un nuovo strumento da imparare, una nuova funzione da testare, una nuova competenza da acquisire. Non sorprende quindi che molti inizino a pensare: “Se non mi aggiorno subito, resterò indietro.”

I report sul mondo del lavoro lo confermano: accanto all’entusiasmo per l’IA cresce anche una pressione diffusa a doverla adottare rapidamente per non perdere competitività.

Gli algoritmi delle piattaforme digitali amplificano questa sensazione, mostrandoci ciò che genera più coinvolgimento emotivo: trend, risultati, novità, successi. Studi sulla diffusione dei contenuti online mostrano che ciò che appare urgente o rilevante si propaga più velocemente, rafforzando l’impressione che “tutti lo stiano già facendo”.

Il cervello, esposto a questi segnali, traduce tutto in un pensiero immediato: “Sta succedendo qualcosa di importante. Non devo perderlo.”

La FOMO, quindi, non nasce solo da ciò che ci manca davvero, ma da ciò che vediamo continuamente. E qui entra in gioco un altro concetto fondamentale: il carico cognitivo.

La mente umana ha risorse limitate, e quando riceve troppe informazioni contemporaneamente cresce il cosiddetto carico cognitivo estraneo, quello che non ci aiuta davvero a imparare ma consuma energia mentale.

Alcune ricerche collegano direttamente la FOMO digitale all’overload informativo, al multitasking continuo e a un conseguente aumento di stress e fatica mentale. In altre parole, la corsa a imparare tutto sull’IA può farci sentire produttivi, ma spesso ci lascia soltanto più stanchi.

La Mindfulness digitale non significa rifiutare l’innovazione, ma imparare a distinguere tra ciò che è veramente utile per noi, ciò che è interessante ma non urgente, e ciò che stiamo seguendo solo perché “lo fanno tutti”.

Prima di adottare un nuovo strumento, può bastare fermarsi un istante e chiedersi:

Mi serve davvero? Migliora qualcosa di concreto nel mio lavoro o nella mia vita? Sto scegliendo con intenzione o reagendo alla paura di restare indietro?

L’Intelligenza Artificiale può essere una risorsa straordinaria, ma solo se smettiamo di usarla per paura e iniziamo a usarla per direzione.

Non serve conoscere ogni tool: serve conoscere quello che ha senso per noi, oggi.

Se questo tema ti risuona, parti da una domanda semplice: stai usando l’IA per scelta… o per FOMO?